Die Standard-Methoden der technischen Zuverlässigkeit sind nicht auf alle Aufgaben der Praxis nützlich anwendbar. Uptime ENGINEERING hat daher im Lauf der letzten Jahre einen umfassenden Satz von speziellen Methoden für den Zuverlässigkeitsprozess entwickelt. Das geschah häufig zur Lösung konkreter Aufgaben im Rahmen von Kundenprojekten. Neuartige Aufgabenstellungen in aktuellen Projekten führen auch aktuell zu einer permanenten Erweiterung der Methodenbibliothek.

Der Schwerpunkt liegt auf Methoden der angewandten Statistik und Schädigungsphysik.

Dabei wird generell ein Design verfolgt, das den durchgängigen Zuverlässigkeitsprozess im Produktlebenszyklus bestmöglich unterstützt. Die Methoden sind daher in Uptime SOLUTIONS in generischer, parametrierter Form implementiert. Sie sind dadurch für alle Anwendungen der Software rasch und ohne Programmierarbeit verfügbar.

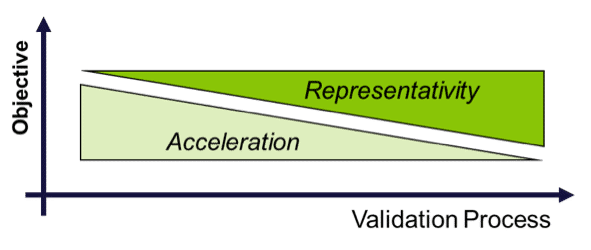

Das Testen simuliert die beabsichtigte Produktnutzung, um Designschwächen aufzudecken. Da sowohl die Time-to-Market als auch die damit verbundenen Kosten kritisch sind, müssen Tests effizient sein, d.h. sie müssen ein Maximum an Informationen innerhalb des vorgegebenen Zeitplans liefern. Um dieses Ziel zu erreichen, werden zwei Arten von Tests intelligent kombiniert:

Beschleunigte Tests (HALT, HASS) werden für gut verstandene Ausfallsmechanismen durchgeführt. Prototypenkomponenten ermöglichen die Testdurchführung in einem sehr frühen Stadium der Produktentwicklung.

Repräsentative Tests zielen darauf ab, alle möglichen Fehlermodi abzudecken – einschließlich unbekannter Phänomene. Das in der Entwicklung befindliche System wird dazu in verschiedenen realistischen Betriebsmodi und Randbedingungen getestet.

Die Tests werden unter Berücksichtigung der Nutzungsmuster des Produkts durch die Kunden entwickelt, so wie sie in der Nutzungsraumanalyse identifiziert wurden. Im Allgemeinen wird die Komponentenprüfung von den Lieferanten durchgeführt mit Aufsicht und Anleitung durch den OEM.

Die Testbeschleunigung wird über die Intensität und die Häufigkeit der Belastung erreicht. Die Testbeiträge zur Validierung gegen verschiedene Ausfallsmechanismen werden über die Schädigungsrechnung ausgewertet, um Über- oder Untertesten zu vermeiden.

Eine ausgewogene Abfolge von beschleunigten und repräsentativen Tests liefert die höchste Effizienz eines Validierungsprogramms. Beschleunigte Tests demonstrieren die Bauteilreife in frühen Phasen der Produktentwicklung. Dies ermöglicht das Front-Loading der Problemlösung. Es hält den Entwicklungsprozess auf Kurs und reduziert Kosten.

Es minimiert die Ausfallrate nachfolgender repräsentativer Tests. Insgesamt führt eine gut durchdachte Testsequenz zur maximalen, tatsächlichen Zuverlässigkeitsdemonstration.

Physics of Failure (PoF) ist ein wissenschaftsbasierter Modellierungsansatz zur Bewertung von schädlichen Auswirkungen als Funktion der Betriebsbedingungen. Es wird auf alle Integrationsebenen von Komponenten bis hin zu kompletten technischen Systemen angewendet.

In der wissenschaftlichen Literatur findet sich ein umfangreicher Satz von Modellen für eine Vielzahl von Versagensmechanismen (Arrhenius, Woehler, Manson-Coffin, Norton, etc.). Die Uptime PoF-Modellbibliothek erweitert dieses Set um ein noch breiteres Spektrum an speziellen Fehlermodi. Darüber hinaus wird in der Software Uptime SOLUTIONS PoF auch für die Entwicklung dedizierter Modelle für bestimmte Fehlermodi eingesetzt.

PoF wird während des Produktlebenszyklus eingesetzt. Während der Konstruktion ist PoF der klassische Ansatz zur systematischen Untersuchung der Robustheit gegen verschiedene Ausfallrisiken. In der Produktvalidierung werden PoF-Modelle zur quantitativen Testbewertung angewendet. Dies dient der Optimierung von Tests gegen verschiedene Arten von Ausfallrisiken (Schädigungsrechnung). Das risikofokussierte Flottenmonitoring stützt sich schließlich auf PoF für die Bewertung des tatsächlichen Belastungsintensität und für die Berechnung der Ausfallwahrscheinlichkeit, also der Restnutzungsdauer.

Die Uptime ENGINEERING PoF-Modellbibliothek bewertet die Kinetik schädigender Mechanismen in generischer Form. Sie liefert die Vorlagen für die Anwendung auf verschiedene Sonderfälle in verschiedenen Produkten und Branchen. Die PoF-Modellanwendung erfordert eine Parametrisierung mit der Belastbarkeit der betrachteten Komponenten. Es ist kein umständliches „data-labeling“ oder zeitaufwändiges Modelltraining notwendig. PoF-Modelle sind transparent, Modellannahmen und -grenzen sind von Ingenieuren leicht zu beurteilen. Dies ist insbesondere bei der Anwendung zur Entscheidungsunterstützung von größter Bedeutung.

Die top-down System-Risikobewertung von Uptime ENGINEERING identifiziert verschiedene Arten von Risiken: Technologie, Zeit, Organisation, Qualität und Wartung. Es berücksichtigt das Systemdesign, die Fertigungsprozesse, die Nutzungsbedingungen, Anwendungen, Lebensdauererwartungen, usw.

Ergänzend zur System-Bewertung werden bottom-up Analysen zur detaillierten Bewertung von Funktions- und Zuverlässigkeitsrisiken eingesetzt.

Die Systemrisiken liefern die Aufgaben für den Zuverlässigkeitsplan, der die Beiträge verschiedener OEM-Teams und Lieferanten organisiert. Er eliminiert nicht-technische Risiken, um die Effizienz der Verifikations- und Validierungstests zu verbessern.

Eine umfassende Risikoanalyse liefert die Grundlage für eine systematische Produktentwicklung, wie sie im Verifikations- und Validierungsprogramm konkretisiert ist. Die Risikoanalyse identifiziert auch Zielkonflikte in einem frühen Stadium der Produktentwicklung. Somit trägt sie zum Frontloading der Problemlösung vor dem kostspieligen Prototyping bei.

Statistik liefert einen leistungsstarken Satz von Methoden, um Korrelationen aufzudecken und Abhängigkeiten in Datensätzen zu beschreiben. Angewandte Statistik im Reliability Engineering umfasst Zuverlässigkeitsdemonstration und Lebensdauer, Regression und Varianz sowie Datenclustering und grafische Darstellungstechniken.

Im Rahmen der Zuverlässigkeit werden statistische Methoden zur permanenten Überwachung und Analyse von Serienfehlern und zur Überprüfung von Ursachenhypothesen eingesetzt. Ihre Kombination mit Physics of Failure ist der Verwendung einzelner Werkzeuge zur Problemanalyse deutlich überlegen. Während der Entwicklung wird der Grad der Zuverlässigkeitsdemonstration mit statistischen Modellen ausgewertet. Sie werden auf Komponenten ( Reifegraddemonstration) und auf Systemebene (MTBF, MDBF, MTTR usw.) angewendet. Schließlich werden im Flottenmonitoring statistische Analysen von Zeitreihendaten wird zur Mustererkennung eingesetzt, um Indikatoren für abweichendes Systemverhalten zu erkennen.

Angewandte Statistik liefert eine quantitative Beurteilung des Zuverlässigkeits-Status. Sie unterscheidet Qualitäts- von Zuverlässigkeitsproblemen und hilft, ihre Ursachen zu identifizieren.

Statistik bewertet das Potenzial eines Testprogramms für den Zuverlässigkeitsnachweis in Planung und Ausführung.

Statistik modelliert das Systemverhalten und quantifiziert Streubänder. Sie bildet damit die Grundlage für die Erkennung signifikanter Abweichungen. Die statistische Lebensdauermodellierung wird im Rahmen der vorausschauenden Wartung eingesetzt.

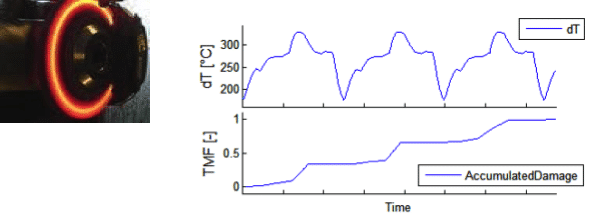

Die Schädigungsrechnung leitet die Schadensakkumulation aus Lastverläufen ab. Dies wird über Physics of Failure-Modelle ausgeführt, die auf Zeitreihen von Lastdaten angewendet werden. Die Last kann mechanischer, thermischer, chemischer und elektrischer Natur sein. Ein entsprechender Satz von Eingabedaten notwendig, um alle Arten von schädlichen Auswirkungen in einem Produkt abzudecken. Ist die Messung dieser Daten an kritischen Stellen nicht möglich, wird aus globalen Lastdaten über Übertragungsfunktionen („virtueller Sensor“) die lokale Last simuliert.

Die Schädigungsrechnung dient der Ermittlung der schädigenden Auswirkungen eines Lastverlaufs. Verschiedene Schädigungsmechanismen werden durch einen entsprechenden Satz von Modellen abgedeckt. In Planungsphasen werden mangles Hardware die notwendigen Input-Zeitreihen simuliert. Messdaten werden ermittelt, sobald Prototypen verfügbar sind.

Schädigungsrechnung ist insbesondere für die Testoptimierung in Bezug auf Referenz-Zyklen nützlich. Sie wird auch für die Testbeschleunigung gegen bestimmte Schädigungsmechanismen verwendet.

Die Schädigungsrechnung liefert einen quantitativen Vergleich der Schadenskinetik für verschiedene Lastverläufe. Vereinfachte Modelle werden sehr früh für die Planung eingesetzt. Eine höhere Genauigkeit wird durch System-Antwort Modellierung oder durch Messung erreicht, die schon während der Design Verifikation durchgeführt wird.

Die meisten der tatsächlichen Zuverlässigkeitsprobleme hängen mit transienten lokalen Spannungen zusammen, die sich aus Gradienten der Last, der Last-Übertragung oder der Belastbarkeit ergeben. Ein bekanntes Beispiel ist die thermische Ermüdung, die durch lokal verzögertes Aufheizen und Abkühlen aufgrund von Gradienten in der thermischen Masse oder Wärmeübertragung entsteht.

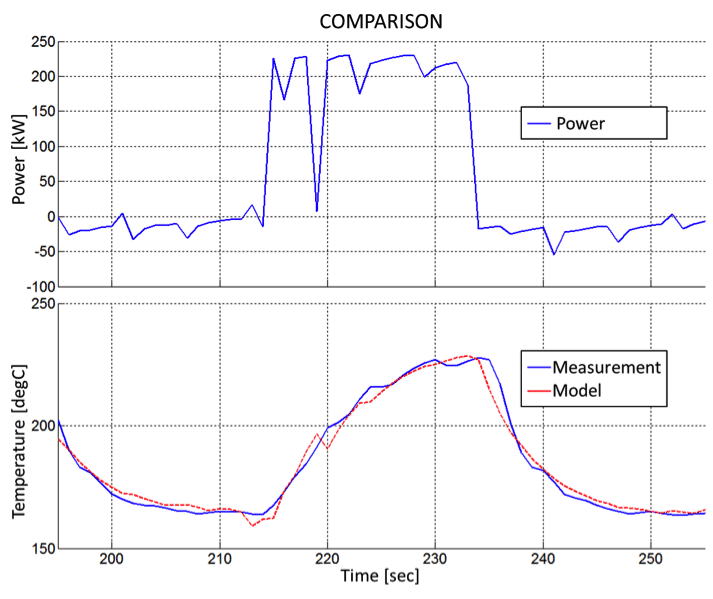

Die Schädigungsrechnung für dynamische Arbeitszyklen erfordert die genaue Bestimmung dieser transienten Kinetik. Da solche Messungen schwierig und kostspielig sind, wird die Modellierung der System-Antwort als Ersatz für die permanente Messung verwendet.

Dazu wird ein einmaliges Messprogramm zur Systemreaktion auf Lastwechsel durchgeführt, um eine Übertragungsfunktion zu parametrieren. Sie bildet die beobachtbaren Lastdaten auf die lokale Last unter transienten Bedingungen ab. Dieses Mapping wird in der Folge als „virtueller Sensor“ für alle Arten von Arbeitszyklen verwendet.

Virtuelle Sensoren werden zur Auswertung von lokalen Lasten unter verschiedenen Arbeitszyklen eingesetzt. Während der Produktentwicklung werden virtuelle Sensoren zur Testbewertung eingesetzt. Beim Flottenmonitoring generieren sie über Residualanalysen den Erwartungs- oder Referenzwert für die Zustandserkennung.

Nach der ersten Messung des Systemverhaltens ist keine zusätzliche Sensorik für weitere Tests oder Lastzyklen erforderlich.

Die System-Antwort Modellierung liefert im Vergleich zum CAE-Ansatz eine hohe Genauigkeit für dynamisches Systemverhalten bei geringem Aufwand. Lastinformationen für verschiedene Positionen innerhalb eines Produkts können ohne Hochfrequenz-Datenermittlung aus globalen Lastdaten abgeleitet werden.

Die meisten der tatsächlichen Zuverlässigkeitsprobleme hängen mit transienten lokalen Spannungen zusammen, die sich aus Gradienten der Last, der Last-Übertragung oder der Belastbarkeit ergeben. Ein bekanntes Beispiel ist die thermische Ermüdung, die durch lokal verzögertes Aufheizen und Abkühlen aufgrund von Gradienten in der thermischen Masse oder Wärmeübertragung entsteht.

Die Schädigungsrechnung für dynamische Arbeitszyklen erfordert die genaue Bestimmung dieser transienten Kinetik. Da solche Messungen schwierig und kostspielig sind, wird die Modellierung der System-Antwort als Ersatz für die permanente Messung verwendet.

Dazu wird ein einmaliges Messprogramm zur Systemreaktion auf Lastwechsel durchgeführt, um eine Übertragungsfunktion zu parametrieren. Sie bildet die beobachtbaren Lastdaten auf die lokale Last unter transienten Bedingungen ab. Dieses Mapping wird in der Folge als „virtueller Sensor“ für alle Arten von Arbeitszyklen verwendet.

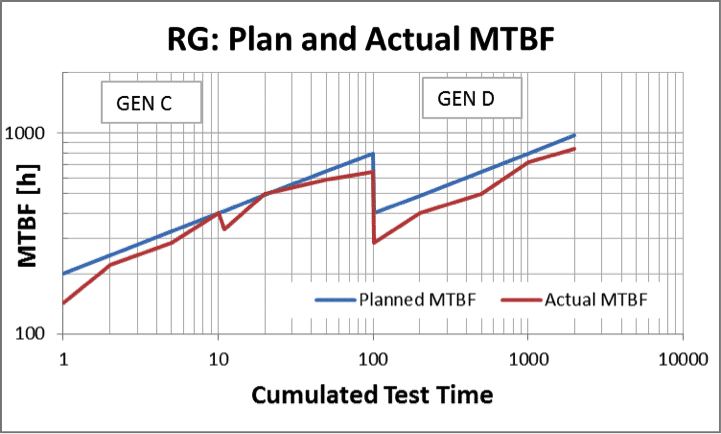

MTBF rstellt die Kundenerwartung dar. Sie quantifiziert, inwieweit das Produkt, was es tun soll.

Darüber hinaus misst MTBF die Qualität des Validierungsprozesses. Somit wird die Analyse des Zuverlässigkeitswachstums auch zur Vorhersage der Zielerreichung eingesetzt.

Mit MTBF wird aus dem großen Volumen verteilter und heterogener Validierungsaktivitäten ein einfacher, aber signifikanter KPI abgeleitet. Er überwacht den tatsächlichen Nachweis der Kundenerwartungen und gibt eine objektive Bewertung des Validierungsprozesses. Durch frühzeitige Anzeige von Serienproblemen wird eine schnelle Reaktion ermöglicht, bevor die Kosten steigen oder Auswirkungen auf das Kundenvertrauen drohen.

Eine sinnvolle Produktentwicklung wird im Hinblick auf zukünftige Produktnutzungsweisen in unterschiedlichen Anwendungen durch verschiedene Kundennutzungsverhalten durchgeführt.

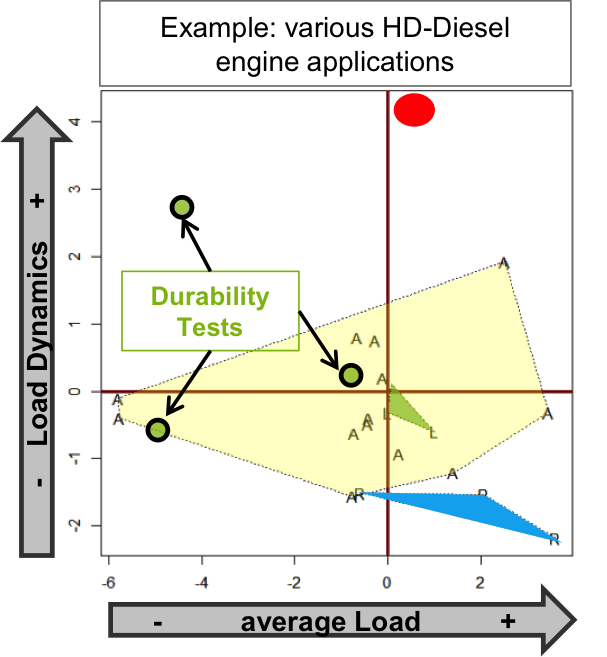

Die Nutzungsraumanalyse ermittelt, wie unterschiedlich diese Bedingungen tatsächlich sind. Die Bewertung verwendet Felddaten, die die Vielfalt künftiger Bedingungen abdecken. Eine Hauptkomponenten-Analyse (PCA) projiziert die gemessenen Last-Variablen in einen – i.A. viel kleineren – Satz unabhängiger Variablen.

Eine Nutzungsraumanalyse liefert die Bewertung der Produktnutzung aus Sicht der Belastung. Darüber hinaus bestimmt sie, Belastung in Dauerläufen relativ zur Kundennutzung. Außerdem werden Ausreißer-Anwendungen identifiziert, die spezifische Tests erfordern, ohne Synergie für andere Anwendungen.

Der Nutzungsraum verknüpft das Testen mit der Vielfalt zukünftiger Lastbedingungen. Er bewertet die Art der Dauerläufe im Hinblick auf die Referenzzyklen der Kunden. In vielen praktischen Fällen zeigt die PCA, dass die tatsächliche Verwendung eines Produkts weniger heterogen ist als erwartet. Dies trägt dazu bei, die Anzahl der Testarten niedrig zu halten, ohne die Qualität eines Testprogramms zu beeinträchtigen.

Die Nutzungsraumanalyse bewertet das Kosten-Nutzen-Verhältnis von Ausreißeranwendungen. Sie liefert auch Testanforderungen auf Grund von Änderungen in Lastprofilen, Anwendungen, Nennleistungen usw.

Die Zuverlässigkeits-Ziele werden für das gesamte System entsprechend den Marktbedingungen festgelegt. Sie werden zerlegt, um einen konsistenten Satz von Komponentenzielen zu erstellen. Die Standardmethode für diese Aufgabe – basierend auf dem Zuverlässigkeits-Blockdiagramm – liefert aber nur für einfache Systeme vernünftige Ergebnisse. Daher berücksichtigt uptime ENGINEERING bei der Zielermittlung die Erfahrung zum System, abgeleitet aus den Ergebnissen der Risikobewertung. Ziele für funktionelle Gruppen werden entsprechend ihrer Komplexität und ihrem Risikoniveau modifiziertabhängiger Variablen.

Die Zuverlässigkeits-Zielermittlung wird verwendet, um die Validierungs-Aufwände entsprechend der Risiken zu verteilen. Ziele für Komponenten mit geringem Risiko wird gestrafft, um Potenzial für eine Reduzierung für Komponenten mit hohem Risiko zu generieren. Damit wird dass reale Potenzial zum Zuverlässigkeitsnachweis mit den tatsächlich verfügbaren Ressourcen akzeptiert.

Das Testvolumen konzentriert sich auf die Risikoschwerpunkte. Die Zuverlässigkeitsziele bleiben tatsächlich nachweisbar und die Gesamteffizienz der Validierung wird optimiert.

Im Gegensatz zur FMEA – die sich auf die Folgen eines Fehlermodus konzentriert – ermittelt die Ausfallspotenzial-Analyse (APA) die Ursachen und die schädigenden Bedingungen für Ausfälle, die sich im Laufe der Betriebszeit entwickeln. In APA-Workshops wird ermittelt, wie ein technisches System oder eine Komponente während des Betriebs aufgrund von Degradation ausfallen kann. Diese Workshops machen das implizite Wissen von Domänenexperten explizit.

Für Ausfallsmechanismen werden in der APA die schädigenden Betriebsbedingungen ermittelt, ihren Observablen, Indikatoren und kritischen Eigenschaften geklärt. Darüber hinaus werden Test-, Simulations- und Qualitätsaktivitäten zur Minderung dieses Risikos identifiziert. Die APA wird damit zur Plattform für die Definition von Validierungsprogrammen und für die risikoorientierte Flottenüberwachung.

Die Reduzierung der Zuverlässigkeits-Risiken ist der generelle Zweck der APA. Dies wird auf verschiedene Arten realisiert:

Die APA liefert eine transparente und gut strukturierte Wissensbasis zu Zuverlässigkeitsrisiken. Durch den Gebrauch der APA in Projekten entsteht und wächst eine Unternehmensreferenz zu Zuverlässigkeitsrisiken.

APA-Ergebnisse sind während des gesamten Produktlebenszyklus von Nutzen: für die Testbewertung und Optimierung von Validierungsprogrammen, für die Qualitätsspezifikation in Bezug auf Zuverlässigkeit, für die risikoorientierte Flottenanalyse.

Die APA ist der Grundstein für den Zuverlässigkeits-Prozess.

Die Prognose ist entscheidend fürdie Entscheidungen im Rahmen der risikobasierten Instandhaltung (CBM, PDM). Sie verbessert die Wartungsqualität zu reduzierten Kosten. Auf der Managementebene unterstützt die Prognose das Risikomanagement und die Budgetierung. Die Risikobewertung generiert die Kriterien für die Bewertung der Effizienz von Aufgaben. Der Nutzungsraum identifiziert technische Ziele in Form repräsentativer Lastzyklen. Schädigungsmodelle liefern eine risikobezogene Testbewertung.

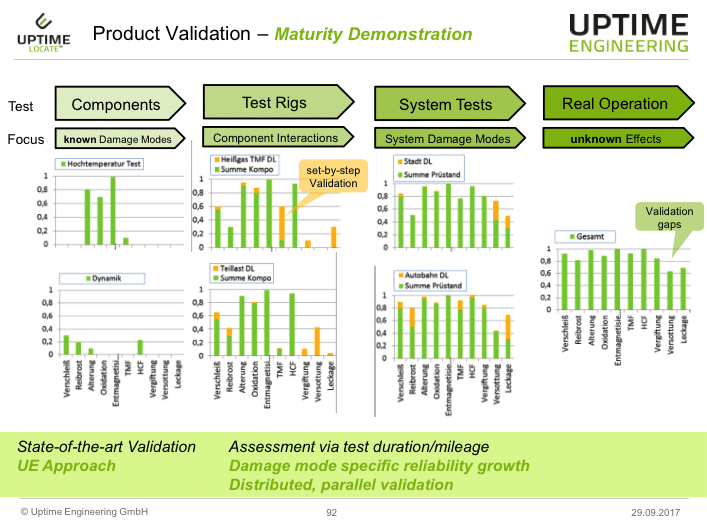

Zur Optimierung der Programme werden bestimmte Ausfallsarten so früh wie möglich mit Komponenten- oder Prüfstandstests zum Nachweis der Bauteilreife behandelt. Anschließend wird das Zusammenspiel der Komponenten validiert. Schließlich wird das komplette mechatronische System repräsentativ getestet, um auch unbekannte Risiken abzudecken.

Die Bewertung der Testbeiträge ermöglicht eine Optimierung der Aufwandsverteilung. Das vermeidet Über- oder Untertesten. Es organisiert die Arbeiten entlang der Lieferkette mit definierten Verantwortlichkeiten. Der Zuverlässigkeitsnachweis wird parallel für verschiedene Produktvarianten mit unterschiedlichen Einsatzbedingungen bewertet.

Nach der Programmplanung wird der reale Nachweis überwacht, um Empfehlungen abzuleiten, wenn Ausfälle auftreten oder Änderungen die Zielerreichung gefährden.

Die Produkte werden gegen eine Vielzahl von Ausfallsmöglichkeiten im Hinblick auf den zukünftigen Kundenbetrieb validiert. Heterogene Nutzungsmodi werden durch ein gemeinsames Programm adressiert. Gleichteil-Synergien werden zur Kostensenkung ohne Qualiätsverlust genutzt.

Lieferanten werden zur Reifegraddemonstration ihrer Komponenten integriert. Der OEM konzentriert sich auf Integrations- und Systemfragen.